O Google lançou a primeira versão do seu Framework de Segurança Frontier, um conjunto de protocolos destinados a abordar os riscos severos que futuros modelos de IA poderosos podem apresentar. Este framework define Níveis de Capacidade Crítica (CCLs) que, quando ultrapassados, exigem medidas de mitigação robustas.

Entendendo o Framework de Segurança Frontier

O Framework de Segurança Frontier do Google é uma iniciativa avançada desenvolvida para mitigar os riscos mais severos associados aos modelos poderosos de Inteligência Artificial (IA). Esse framework é essencial porque, à medida que os modelos de IA se tornam mais sofisticados e influentes, também crescem os riscos e desafios a eles associados.

Os desafios que o Framework de Segurança Frontier visa abordar incluem, entre outros, a propagação de desinformação, a invasão de privacidade, o viés algorítmico, e a perpetuação de discursos de ódio. Esses riscos não são hipotéticos; exemplos conhecidos incluem o uso de IA para criar deepfakes convincentes que podem ser usados para propaganda ou extorsão, e modelos de IA que inadvertidamente perpetuam preconceitos sociais porque foram treinados em dados tendenciosos.

Para enfrentar esses riscos, o framework é estruturado em várias camadas de segurança e diretrizes específicas. Primeiramente, ele estabelece um rigoroso processo de auditoria e verificação para identificar vulnerabilidades nos modelos de IA antes de serem lançados comercialmente. Adicionalmente, incorpora uma monitorização contínua desses modelos post-implementação para garantir que não desenvolvam comportamentos indesejados ao longo do tempo.

O framework também promove a transparência, incentivando a documentação completa do processo de treinamento, das fontes de dados utilizadas e das metodologias empregadas. Essa abordagem permite que outros pesquisadores e partes interessadas verifiquem e critiquem o funcionamento interno dos modelos de IA, promovendo uma cultura de responsabilidade e melhoria contínua.

Outra estratégia vital no Frontier Framework é a implementação de “kill switches”, ou interruptores de emergência, que podem desativar um modelo de IA rapidamente se este começar a causar danos imprevistos.

Conclusivamente, o Framework de Segurança Frontier representa um passo importante e proativo na criação de um ambiente mais seguro e controlado para o desenvolvimento e uso de tecnologias de IA avançadas, garantindo que essas ferramentas poderosas sejam usadas de maneira ética e segura.

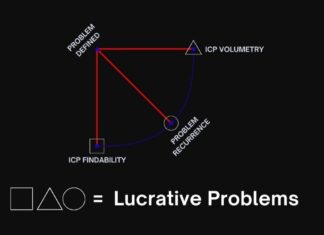

Níveis de Capacidade Crítica (CCLs)

Os Níveis de Capacidade Crítica (CCLs) são um elemento central do Framework de Segurança Frontier, representando pontos de controle cruciais na avaliação de modelos de IA em termos de seu potencial impacto e risco. Esses níveis são definidos com base na capacidade técnica dos modelos e nas potenciais consequências negativas em vários contextos de uso.

Os CCLs são categorizados conforme a complexidade e o poder do modelo de IA. Modelos que exibem capacidade de geração autônoma de códigos complexos, por exemplo, atingem níveis críticos mais altos devido ao risco de serem utilizados para criar malware sofisticado. Da mesma maneira, IA com a habilidade de gerar deepfakes realistas pode alcançar altas CCLs devido ao seu potencial de causar desinformação e fraude.

A identificação de modelos que ultrapassam esses níveis críticos envolve uma análise detalhada das funcionalidades técnicas, do treinamento e das aplicações práticas dos modelos. Através desta análise, o Google consegue mapear os potenciais riscos e, consequentemente, atribuir um CCL adequado a cada modelo.

Um exemplo prático de CCL poderia ser um modelo de IA responsável por decisões financeiras automatizadas. Se seu nível de capacidade permitir autonomia em transações de alto valor, ele atinge um CCL elevado devido aos riscos de fraudes e falhas financeiras massivas. Outro exemplo inclui modelos de IA usados em diagnósticos médicos; se forem imprecisos, podem resultar em diagnósticos errados que afetam a saúde dos pacientes.

Essas implicações tornam essencial que o desenvolvimento e implementação de modelos de IA sejam alinhados com os níveis de CCLs estabelecidos. O uso deste framework ajuda a assegurar que as inovações em IA sejam monitoradas e reguladas para minimizar riscos severos à sociedade.

Mitigações de Segurança

Para mitigar os riscos associados à exposição dos pesos de modelos de IA que ultrapassam os Níveis de Capacidade Crítica (CCLs), o Google recomenda uma série de medidas de segurança robustas e específicas. Uma das importantes recomendações é **codificar os pesos dos modelos** com algoritmos de criptografia avançados. Isso garante que, mesmo que os pesos sejam obtidos não autorizadamente, sua utilidade será limitada sem a chave de decriptação correta.

Além disso, o Google enfatiza a necessidade de **controle de acesso rigoroso**. Apenas indivíduos ou sistemas devidamente autorizados devem ter acesso aos pesos dos modelos. Isso pode ser implementado através de esquemas de autenticação multifatorial (MFA) e gestão de identidades e acessos (IAM) para fortalecer a segurança.

Outra mitigação sugerida é o uso de **mecanismos de monitoramento e auditoria contínuos**. Estes sistemas servem para detectar e responder rapidamente a quaisquer tentativas de acesso não autorizado. Alertas em tempo real e análises de atividades suspeitas podem ser integrados para aumentar a vigilância.

Um exemplo prático da implementação dessas recomendações é a criação de **repositórios seguros e isolados** para armazenar os pesos dos modelos. Estes repositórios devem ser protegidos por medidas de segurança física e lógica, garantindo que somente processos especificamente permitidos possam acessá-los.

A **importância de evitar a exposição dos pesos** dos modelos que ultrapassam os CCLs é crucial, pois tal exposição pode levar ao uso inadequado ou maligno da IA, prejudicando indivíduos e sociedade. Modelos poderosos nas mãos erradas podem ser utilizados para criar deepfakes convincentes, realizar campanhas de desinformação ou até mesmo explorar vulnerabilidades na segurança de sistemas críticos. Portanto, assegurar a confidencialidade e integridade dos pesos é um passo vital para prevenir tais abusos.

A implementação coerente dessas contramedidas garante que, mesmo em caso de comprometimento, os riscos associados sejam significativamente minimizados, permitindo que os avanços em IA continuem beneficiando a sociedade de maneira segura e controlada.

Mitigações de Implantação

Para mitigar os riscos associados à implantação de modelos de IA que ultrapassam os Critérios de Complexidade de Limite (CCLs), o Framework de Segurança Frontier da Google propõe uma série de medidas e estratégias cuidadosamente delineadas. Entre essas estratégias, destaca-se a adoção de técnicas de controle de acesso robusto que restringem quem pode interagir com o sistema de IA. Utilizando um sistema de autenticação multifator, combinado com políticas de acesso baseadas em função, é possível garantir que apenas indivíduos autorizados possam realizar determinadas operações no modelo.

Outra mitigação crucial é a implementação de auditorias e monitoramento contínuo. A Google recomenda a utilização de ferramentas avançadas de logging e análise que rastreiam todas as interações com o modelo de IA. Por exemplo, o uso de tecnologias como Google Cloud Logging pode fornecer um registro detalhado das operações realizadas, ajudando a identificar comportamentos anômalos ou acessos não autorizados em tempo real.

Para complementar essas práticas, o framework sugere a integração de mecanismos de detecção de uso indevido, que podem ser implementados através de algoritmos de aprendizado de máquina que monitoram padrões de uso e sinalizam atividades suspeitas. Esses sistemas podem ser treinados para reconhecer tentativas de extração de dados massivos ou manipulações maliciosas.

Além disso, a Google recomenda a segmentação de dados sensíveis por meio de técnicas de criptografia avançada. O uso de criptografia ponta a ponta protege os dados em trânsito e em repouso, tornando-os inacessíveis a partes não autorizadas mesmo em caso de violação de segurança.

Com essas medidas, o Framework de Segurança Frontier não apenas mitiga o risco de uso indevido, mas também garante que o deployment de modelos de IA poderosos sejam realizados de maneira ética e segura, respeitando os padrões mais elevados de proteção e privacidade.

Futuro da Segurança em IA

O impacto do Framework de Segurança Frontier no panorama da segurança em IA promete ser profundo. Com a introdução dessa iniciativa, o Google não apenas se posiciona como um líder em responsabilidade e segurança tecnológica, mas também abre caminho para que outras empresas sigam o mesmo caminho.

**Primeiramente**, espera-se que o exemplo do Google incentive outras gigantes da tecnologia a adotar protocolos similares. Isso poderá desencadear um efeito dominó, onde a pressão competitiva e as expectativas regulamentares levem à implementação de práticas mais rigorosas de segurança em IA por parte de outras organizações.

**Além disso**, o Framework de Segurança Frontier pode estabelecer novos padrões na indústria. Ao proporcionar um conjunto de medidas e best practices, torna-se uma referência para a criação de normativas e guidelines internacionais. Essas novas diretrizes não apenas aumentariam a segurança global, mas também poderiam harmonizar práticas entre diferentes países, facilitando a cooperação e o compliance legal.

**Essas mudanças** sinalizam um futuro onde a segurança em IA se tornará uma prioridade central e não um simples complemento à inovação tecnológica. Com a pressão crescente por mais transparência e governança, as empresas serão incentivadas a investir em pesquisas e avançarem em métodos de mitigação.

**Contudo, é crucial** reconhecer que a segurança em IA é um campo em contínua evolução. A medida que os modelos de IA se tornam mais avançados, as estratégias de mitigação também precisam se adaptar. Portanto, o Framework de Segurança Frontier não deve ser visto como um projeto estático, mas sim como um passo inicial em uma jornada contínua de aprimoramento e inovação.

Esperamos que, **no futuro próximo, essa** iniciativa revolucione a forma como abordamos a segurança em IA, promovendo um ambiente tecnológico mais seguro e confiável. As expectativas são altas, especialmente em termos de equilibrar inovação e responsabilidade, estabelecendo um novo marco na segurança digital global.

Concluindo

O Framework de Segurança Frontier do Google representa um passo significativo na mitigação de riscos severos associados aos modelos de IA. Através da definição de Níveis de Capacidade Crítica e medidas de mitigação robustas, o Google busca estabelecer um padrão de segurança que poderá moldar o futuro da IA e proteger tanto os desenvolvedores quanto os usuários.